OpenAIとBroadcomの協業の概要

2025年10月13日、ChatGPTの開発元であるOpenAIは半導体企業のブロードコム(Broadcom)と、人工知能(AI)向けカスタム半導体とネットワーク機器の共同開発で複数年にわたって協力することに合意しました。両社は2026年以降、OpenAIが設計したAIアクセラレータ(カスタム半導体)とブロードコムのイーサネット等のネットワーク技術を組み込んだサーバーラックを共同開発・導入し、最大10GW(ギガワット)級のAIコンピューティング能力を4年以内に展開する計画です。この計画は、OpenAIがNVIDIAやAMDに依存していたコンピューティングインフラを自社開発の専用チップで補完・代替する狙いを示しており、同社のAIモデル開発とサービス提供を支える基盤強化を図るものです。

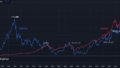

OpenAIとBroadcomの契約について、コストや金銭的条件などは記事作成時点で明かされていません。Broadcomの2025年9月の決算報告には100億ドル(約1兆5000億円)規模の顧客が含まれていましたが、OpenAIと契約後のCNBCのポッドキャストに出演したBroadcomの半導体ソリューション部門社長であるチャーリー・カウワス氏は「100億ドル規模のパートナーはOpenAIではない」とウワサを否定しました。ウォール・ストリート・ジャーナルの報道によると、この契約は数十億ドル(数千億円規模)のものになるとのことで、Broadcomの株価は発表当日の午前中の時点で10%近く上昇しています。また、事情に詳しい関係者によると、アルトマンCEOは「2033年までに250GWのコンピューティング能力を構築したいと考えている」と従業員に伝えているそうで、数兆円を超える費用をどのように調達するか注目されています。

このOpenAI×Broadcomの提携は、2025年9月末にNVIDIAとの間でも発表された同様の協業に続くものです。NVIDIAは同社のGPU数百万基に相当する10GW規模のシステムを構築する戦略的パートナーシップを結ぶことを明らかにしており、さらに2025年10月6日にはAMDとの提携も発表し、合計6GWのAMD Instinct GPUを導入する複数世代の契約を結んだことを明らかにしています。このようにOpenAIはNVIDIAやAMDの汎用GPUに加え、自社設計のカスタムAIチップも投入する多角的な戦略を打ち出しており、総合的なコンピューティング能力を確保しようとしています。

OpenAIのAIコンピューティング需要と戦略

OpenAIは2023年のChatGPT爆発的な人気以降、そのAIサービスのユーザー数や需要が急増しています。現在OpenAIは約2GW(約200万kW)規模のコンピューティング能力で稼働していますが、これでもChatGPTの拡大や、新モデルの開発・発表(2023年末には動画生成サービス「Sora」の公開など)に必要な計算資源を賄っています。ところが、AI技術の急速な進化に伴い需要は飛躍的に増大しており、現在の規模ではまもなく飽和してしまう可能性があると指摘されています。実際、OpenAIのアルトマンCEOは「もし今のモデル性能で30GW規模の計算資源があったら、それをすぐに人々が使い切ってしまうだろう」と述べており、今後さらに大規模なAIモデルを開発・運用していくためには、数倍から十数倍規模の計算能力が必要になると見込まれています。

そこでOpenAIは、ハードウェアインフラのスケーリングに向けて大胆な戦略を打ち出しています。まず2025年9月には、NVIDIAとの間で最大10GWのNVIDIA製GPUを導入する契約を結びました。この契約はNVIDIAによるOpenAIへの最大1000億ドル規模の投資とも関連しており、NVIDIAはOpenAIの新インフラ構築に協力することで、自社の高次世代GPUの需要を確保する狙いもあります。続いて10月には、AMDとも提携し、AMDの最新GPU「Instinct MI450」を含む合計6GWのシステムを複数世代にわたり導入する計画を発表しました。このAMDとの協業では、AMD株の取得権(ウォーラント)も付随しており、AMDの株価上昇に応じてOpenAIがその価値を享受できる仕組みとなっています。さらに、本稿で述べたBroadcomとの協業では、OpenAIが設計したカスタムAIアクセラレータを10GW規模で導入します。これらの計画を総合すると、OpenAIは数ヶ月で最大33GW規模のコンピューティング能力を確保することに成功しており、今後もさらなる拡大を図っていくと見られます。

OpenAIがこれほど大規模なインフラ投資を行う背景には、自社のAIモデル開発とサービス提供をより強固に支えるためです。具体的には、新しいモデルを訓練するための計算力や、膨大なユーザーからのAIサービス要求に応えるためのインフラが必要になるためです。また、OpenAIは2023年以降米政府とも協議を進め、AI研究・開発に必要なインフラ強化や人材育成の支援を求めています。例えば、米科学技術政策室(OSTP)からの情報提供依頼に対してOpenAIは「米国のAIインフラ強化について包括的な計画」を提出し、「AIインフラへの1兆ドル投資が3年で米国GDPを5%以上拡大させる可能性がある」との内部分析を示しています。このようにOpenAIは、自社の将来的な発展に伴い必要とするインフラ投資について、政策面からも支援を求める動きを見せています。

さらにOpenAIは、インフラ戦略として自社が独自のAIチップを開発・投入することを強く意図しています。OpenAIは2023年から既に自社の専用AIプロセッサ開発を進めており、NVIDIAやAMDのGPUに頼らずにAI計算を行うための技術を蓄積しています。同社は2024年時点でBroadcomと協力して最初のAIチップ設計を行い、台湾のTSMCで製造する計画を立てていたと報じられています。また、2025年には米ロイターが「OpenAIが自社のAIチップ製造を検討中で、潜在的な買収対象の評価まで行っている」と報じており、自社チップ戦略を加速させている様子が伺えます。今回のBroadcomとの提携も、その自社チップ戦略の一環であり、OpenAIは自社で設計したハードウェアを製造・投入することで、最新のAIモデル開発で得た知見をハードウェアに直接組み込み、新たな能力を引き出せるようにしています。実際、OpenAIのグレッグ・ブロックマン最高経営責任者(COO)は「自社チップ開発により、先端モデルや製品開発で得た知見をハードウェア設計に直接取り入れ、新たなレベルの知能能力を引き出せる」と述べています。このようにOpenAIは、ソフトとハードの両面でAI技術を最適化し、独自のAIインフラを構築することで、今後の競争優位を確保しようとしています。

BroadcomのAI半導体戦略と技術力

ブロードコムはiPhoneや光通信向け半導体など幅広い分野で技術を展開する米国の大手半導体企業です。特に近年、ブロードコムは「AI向けカスタムプロセッサ(XPU)」と呼ばれる専用AIチップの開発・供給に積極的に取り組んでおり、AIブームの大きな恩恵を受けています。ブロードコムのAI半導体部門は、主に2つの収益源から得ています。それは、①顧客向けにカスタムAIアクセラレータを開発・提供する事業、および②サーバーやネットワーク機器に搭載する標準部品の販売です。前者は「XPU」事業で、GoogleのTPUなど大型クラウド企業のカスタムAIチップを生み出している領域です。ブロードコムは長年にわたり、グローバル企業の高性能ASCIを量産に成功させており、この知見を活かして最新のAIアクセラレータにも応用しています。また後者は、データセンター用のサーバー・ネットワーク部品(イーサネットスイッチ、PCIeスイッチ、NICなど)の販売で、OpenAIとの協業でも提供する領域です。

ブロードコムの技術力を代表するのが、最先端の半導体プロセスとパッケージ技術の活用です。ブロードコムはTSMCなど製造業者と協力し、最新の3nmプロセスや2.5D/3.5Dチップスタック技術を駆使したXPU開発に成功しています。具体的には、2025年12月にブロードコムは「業界初の3.5D フェイス・トゥ・フェイス(F2F)チップスタック技術を導入したAI向けXPUを量産に入れた」と発表しました。このXPUは、4つの計算ダイと1つのI/Oダイ、さらに6つのHBMメモリモジュールを組み合わせた構造を持ち、TSMCの最先端プロセスノードと2.5DのCoWoS®パッケージ技術を活かしています。ブロードコムの独自設計フローと自動化手法により、この超複雑なチップも一度で機能を発揮する成果が出ており、高速SerDesやHBMインターフェース、ダイ間接続など主要IPブロックで優れた性能を示しています。

ブロードコムの3.5D XDSiP™(eXtreme Dimension SiP)プラットフォームは、従来のF2B(フェイス・トゥ・バック)方式に比べてインターコネクト密度と電力効率を大幅に向上させるものです。このF2Fスタック技術は、上層ダイと下層ダイの最上部金属層を直接接続することで、電気的干渉が少なく機械的強度も高い高密度な接続を実現しています。また、F2B方式ではダイ間インターコネクトに平面型のPHYが必要だったのに対し、F2F方式では3DのHCB(High Bandwidth Connector)を用いることで、ダイ間インターフェースの消費電力を10倍削減し、ダイ間の遅延も大幅に短縮しています。さらに、3.5Dスタックによりコンピュート・メモリ・I/O各ブロック間の距離が近づき、レイテンシの低減とコンパクトなパッケージ化が可能になっています。これにより、パッケージサイズを小さくしつつ性能とコスト効率を向上させることができます。

ブロードコムはこのような最先端技術を活用したXPUを既に複数開発しており、2025年末以降には大手クラウド企業向けに量産供給を開始しています。例えば、GoogleのTPU v7にもブロードコムが参加しており、ブロードコムは「GoogleのTPU v7への協力を継続することで、10GW以上の定常的な収入を確保することができる」との見通しを示しています。このようにブロードコムは、グローバル企業のカスタムAIチップ需要に応えることで、自社の技術力を裏付けると同時に、AIブームの利益を得ています。

加えて、ブロードコムはソフトウェア・ネットワーク分野でも強みを持っています。OpenAIとの協業では、ブロードコムのイーサネットスイッチやNICを用いてAIクラスタのスケールアウト(拡張)を実現する計画です。ブロードコムは業界で標準的なイーサネット技術を持ち、高帯域で低遅延のネットワーク接続を提供できるため、OpenAIの大規模AIクラスタにおいてもスケーラビリティと安定性を確保することが期待されます。さらにブロードコムは他にも、CPUやPCIeデバイスのコントローラ、データセンター用のメモリコントローラなど幅広い半導体IPを持っており、OpenAIが自社チップを設計する際にも必要な技術基盤を提供できると考えられます。このようにブロードコムは、「カスタムAIチップ開発」と「標準ネットワーク機器」という2つの分野で強みを持ち、OpenAIのような顧客のニーズに応えるための包括的なソリューションを提供できる体制になっています。

OpenAI×Broadcomの協業による影響と今後の展開

OpenAIとBroadcomの協業は、AIインフラ産業における大きなイベントであり、今後のAIチップ時代における重要な転換点となる可能性があります。以下、その協業の影響と今後の展開について分析します。

AIインフラ産業の変革

OpenAI×Broadcomの協業は、AIコンピューティングインフラの領域で、NVIDIAが長年独占的に牽引してきた状況に変化をもたらすと考えられます。従来、大規模なAIモデルの訓練や運用にはNVIDIAのGPUが主役であり、その性能とソフトウェアエコシステム(CUDAなど)に対する依存度が高かったため、コストや供給面のリスクも伴いました。OpenAIはそうした状況を打破すべく、自社チップとNVIDIA・AMDのGPUを組み合わせる多角的な戦略を取っており、これにより単一ベンダーに対する依存を低減しつつ、必要な計算能力を確保しようとしています。特にOpenAIとBroadcomの協業では、OpenAIが設計した専用AIチップを採用することで、モデル訓練や推論に最適化されたハードウェアを構築できる点が注目されます。例えば、モデルの学習アルゴリズムやメモリアクセスパターンをチップ設計に直接反映することで、効率的な計算を行い、性能を飛躍的に高めることが可能になります。また、ハードウェアとソフトウェアを一体設計することで、モデルの推論スピードやエネルギー効率を向上させ、サービス提供コストを削減できると期待されます。

さらに、OpenAIが自社チップを導入することで、NVIDIAに対する依存を減らし、OpenAI自身のエコシステムを強化できる可能性があります。OpenAIは既にMicrosoftやGoogleなどの大手企業とも協業関係にありますが、自社チップを持つことでOpenAIのAIサービスを運用するインフラを自前で提供できるようになり、独自のエコシステムを構築できるでしょう。実際、OpenAIのブロックマンCOOは「自社チップ開発により、先端モデルや製品開発で得た知見をハードウェア設計に直接取り入れ、新たなレベルの知能能力を引き出せる」と述べており、OpenAIはハードとソフトの両面で統合されたAIプラットフォームを実現しようとしています。これにより、OpenAIは将来的にはクラウドサービスだけでなく、自社の専用AIインフラを販売・提供するビジネスモデルも模索できるでしょう。事実、OpenAIのCFOは「将来的にOpenAIが、クラウドや『ネオクラウド』のようなAIインフラサービスを提供する可能性がある」と述べており、自社チップを中心に構築するインフラエコシステムを展開する意図が伺えます。

OpenAIのエコシステム戦略

OpenAI×Broadcomの協業は、OpenAIのエコシステム戦略の一環として重要な意味を持ちます。OpenAIは現在ChatGPTやDALL-Eなどのサービスを提供していますが、将来的にはAIソフトウェアだけでなく、それを動かすハードウェアインフラまで含めた包括的なエコシステムを構築したいと考えていると推察されます。自社チップを持つことで、OpenAIはソフトウェアとハードウェアの両面で自社のプラットフォームを制御でき、他社による影響を受けにくくなります。また、自社チップを使うことでOpenAIのモデル開発サイクルを短縮し、新機能を迅速に試験・実装できるようになるでしょう。

さらに、OpenAIは自社チップ開発によって、AI研究コミュニティや開発者エコシステムとの関係も変える可能性があります。現在、OpenAIはクラウドAPI経由でサービスを提供していますが、自社チップを投入することで、将来的にはOpenAIのモデルを自社インフラ上で実行できるオンプレミス版を提供することも考えられます。これにより、政府機関や企業がセキュリティ上の理由でOpenAIのクラウドにデータを送りたくない場合でも、自社内でAIモデルを動かすことが可能になり、OpenAIのサービス利便性を高めるとともに、新たな顧客層を開拓できるでしょう。実際、OpenAIは2023年に米国の国家実験室に対し、自社の高度なAIモデルをオンプレミス環境で導入する取り組みを行っており、今後もオンプレミスAIサービスの提供に注力すると見られます。こうした動きは、AIインフラのオープン性や分散化につながり、OpenAIが単なるサービス提供企業から、インフラプラットフォーム企業へと転身する可能性を示唆しています。

Broadcomの市場シェアと新たな成長機会

OpenAIとの協業は、Broadcomにとっても極めて大きな成長機会となるでしょう。ブロードコムはAI向けカスタムチップ市場で、既にGoogleなどの主要顧客と長年の関係を築いてきましたが、OpenAIとの提携はさらにその市場シェアを拡大させるでしょう。Broadcomのチャーリー・カウワス氏は「OpenAIとの協業は、AIデータセンターのスケールアップ・スケールアウトにおけるイーサネット技術の選択肢を強調するものである」と述べており、ブロードコムのイーサネットスイッチやNICが今後のAIクラスタの基盤技術として採用される可能性を示唆しています。

また、Broadcomは今後のカスタムAIチップ市場で、NVIDIAやAMDと競合する立場にもなり得ます。NVIDIAは現在、自社GPUの他にデータセンター用のチップセットやインターコネクト技術を持ち、AIクラスタ全体をカバーする包括的なソリューションを提供しています。しかし、OpenAIのような顧客が自社チップを導入する流れが広がれば、NVIDIAにとっては顧客の一部が流失するリスクがあります。一方、BroadcomはOpenAIに対して専用チップとネットワーク機器を一括提供できるため、「チップ+ネットワーク」という包括的ソリューションを強みに持つことで、NVIDIAに対抗する存在になり得ます。実際、ブロードコムは既に「OpenAIとの協業により、オープンでスケーラブルかつ省電力なAIクラスタ設計・展開の業界標準をさらに高める」と述べており、自社の技術で業界基準を定める狙いもあるようです。これにより、ブロードコムはカスタムAIチップ市場における地位を一層強固にし、新たな収益源を確保できるでしょう。

また、ブロードコムは今後、OpenAI以外の大手クラウド企業にも自社のXPUを提供する可能性があります。GoogleやMeta、Amazonなどは既に自社の専用AIチップ(TPU、MTIA、Trainiumなど)を開発・投入しており、ブロードコムがOpenAIに成功したモデルを他社にも提供することで、市場を広げられるでしょう。実際、ブロードコムのカスタムAIチップ事業は近年急成長しており、2024年度の同事業収益は約122億ドルに達し、前年比200%以上の伸びを示しました。この成長はブロードコムの株価上昇にも直結し、2023年末から2024年にかけて株価は6倍にも達しました。OpenAIとの協業はこの成長を一層加速させ、ブロードコムの「XPU」事業が今後も高速成長することが期待されます。

その他のAIチップ開発動向

OpenAI×Broadcomの協業は、AI半導体産業全体の動向を象徴するものです。近年、NVIDIAやAMDによる汎用GPUに頼らず、各社が自社専用のAIアクセラレータを開発・投入する動きが広がっています。GoogleのTPUは最も有名ですが、Metaは2023年に初の自社AIチップ「MTIA(Mana TPU)」を試験的に導入し、Microsoftも「Maia」というAI向け専用プロセッサを開発中です。さらに、IBMは自社のAIチップ開発に注力し、ソフトバンクは約9700億円でデータセンター向け半導体企業(Nuvia社)を買収するなど、AIインフラに力を入れる企業が相次いでいます。こうした動きは、NVIDIAやAMDのGPUに対する依存度を下げ、各社が自社のモデルに最適化されたハードウェアを構築することで、コスト削減や性能向上を図ろうとする試みです。

OpenAI×Broadcomの協業は、この動きをさらに加速させる要因となるでしょう。ブロードコムのカスタムAIチップ技術がOpenAIのモデルに適用されることで、専用AIチップの実用性と効果が示されれば、他の企業も追随して自社チップ戦略を強化する可能性があります。例えば、Amazonは既に「Trainium」(訓練向けAIチップ)や「Inferentia」(推論向けAIチップ)を自社で開発していますが、OpenAIの事例が成功すれば、より大規模な投入や技術革新につながるでしょう。また、日本の企業でも富士通や日立製作所などがデータセンター向けAIチップ開発に着手しており、国際競争が激化する中、OpenAI×Broadcomの協業は海外企業の先駆けとなるでしょう。

今後の予測と展望

OpenAIとBroadcomの協業が実現したことを契機に、AIチップ時代の展開についていくつかの展望を示します。

- 自社チップ導入のスケジュールと進捗: OpenAIは今後数年で自社チップを量産・投入する計画ですが、その進捗は技術的な難易度もあり注目されます。実際、OpenAIが自社チップを開発する際には、TSMCの3nmプロセスで製造するとの情報があります。3nmプロセスはトランジスタの微細化により性能向上や消費電力低減が期待できますが、製造プロセス自体が難しく、生産遅延や歩留まり不良のリスクもあります。また、AIチップには大量の高帯域メモリ(HBM)を搭載する必要があり、HBMの供給も安定していないため、これらの要素が進捗を左右する可能性があります。ブロードコムのカウワス氏は「この規模で新しいハードウェアを統合するのは険しい道のりだ」と述べており、OpenAIとBroadcomの協業にも技術的・計画的なリスクが伴うことを示唆しています。しかし、OpenAIはこれまでのAI開発で見せたように大胆なスケジュールをこなしてきた企業であり、今回も可能な限り早く自社チップを投入する狙いがあると考えられます。実際、2025年10月にはOpenAIが「自社初のAIプロセッサの設計を今年内に完了する」と発表しており、TSMCによる量産開始を2026年に見据えているとの情報もあります。今後数ヶ月から1年以内に、自社チップの試作やテストが進めば、OpenAIの計画に沿ったスケジュールを達成できる可能性があります。

- 性能・コスト効率の向上: OpenAIが自社チップを投入することで、期待されるのはAIモデルの性能向上とコスト削減です。モデルの訓練においては、専用チップが最適化されたアーキテクチャにより、訓練時間を短縮したり、モデルサイズを拡大して精度を向上させることができるでしょう。例えば、OpenAIはGPT-4以降のモデルで巨大な計算資源を投入しており、自社チップによってさらに大規模なモデルを訓練できれば、より高性能なAIモデルを開発できるでしょう。また推論(実際のサービス提供)においても、自社チップによる効率化により単位トークンあたりのコストを下げることができ、サービス提供価格を引き下げる余地が生まれます。これはOpenAIがChatGPTの利用料金を下げるなど価格競争力を高める効果があり、サービスの普及拡大につながる可能性があります。また、エネルギー効率の向上も重要なポイントです。AIコンピューティングは電力消費が膨大であり、効率的なチップ設計によって電力使用量を削減できれば、データセンター全体の運用コストを下げることができます。OpenAIは自社チップによって「エネルギー効率を飛躍的に高め、より高速で安価なモデルを提供できる」と述べており、これらの期待が現実化すれば、AIインフラの持続可能性やコスト構造に大きな影響を与えるでしょう。

- 市場への波及効果: OpenAI×Broadcomの協業は、他の企業や投資家にも波及効果を及ぼすでしょう。まず、他のAI企業にとっては「OpenAIがここまで大規模な自社チップを投入する」という動きを受けて、自社でもハードウェア戦略を再検討する可能性があります。特に、NVIDIAやAMDに頼っている企業にとっては、OpenAIの事例を見て自社でも専用チップを開発するか検討する圧力が高まるでしょう。これにより、AIインフラ市場の競争が激化し、技術革新が加速すると予想されます。また、投資家にとっては、AIチップ分野が今後さらに注目されるでしょう。OpenAI×Broadcomの協業が報じられた直後に、Broadcomの株価が急騰したことはその一例です。今後もAIチップ開発に積極的な企業(NVIDIAやAMD、Broadcom、IBMなど)の株価が上昇する可能性があり、ベンチャー資本や投資家もこの分野への投資を増やすでしょう。さらに、各国政府や産業界もAIチップインフラに関心を寄せ、補助金や研究支援を拡充する可能性があります。米国ではAIインフラへの投資促進策が議論されており、OpenAIのような成功事例が示されれば、政府によるAIチップ研究開発への資金供給や、自国でのAIチップ製造拠点整備などの政策が進むでしょう。

- 社会・産業への影響: OpenAI×Broadcomの協業が実現することで、AI技術そのものの進歩と普及にも影響を与えるでしょう。高性能なAIモデルが大量生産されることで、各産業でのAI活用が加速し、新たなサービスや製品が生まれる可能性があります。例えば、自動運転や医療診断、製造業の品質管理など、多岐にわたる分野でAIが高度化することで、社会的な生産性向上やサービス水準の向上が期待できます。また、AIチップのコスト削減により、企業や個人が利用するAIサービスの価格が下がることで、より多くの人々がAIを活用できるようになります。これは社会全体のイノベーションを促進し、経済成長にも貢献するでしょう。さらに、OpenAIが自社チップを持つことで、AIの安全性や倫理面の課題にも影響を与えるでしょう。自社チップを使うことでOpenAIはモデルの挙動や学習過程を詳細に把握できるため、モデルの偏りや有害な出力を検出しやすくなり、適切な対策を講じやすくなる可能性があります。また、自社チップによってAIのエネルギー消費を抑えられれば、CO2排出削減など環境面でもメリットがあります。

以上のように、OpenAIとBroadcomの協業はAIチップ時代の幕開けとも言える出来事です。OpenAIは自社チップを武器に独自のAIエコシステムを構築し、BroadcomはカスタムAIチップ市場でリーダーシップを確立しようとしています。この協業が成功すれば、AIインフラ産業は大きな変革を遂げ、今後のAI技術の進歩と社会への影響は飛躍的なものになるでしょう。一方で、技術的・経済的なリスクも伴うため、今後の動向を注視していく必要があります。OpenAI×Broadcomの試みは、AI半導体の新時代を切り開く鍵となるかもしれません。

コメント